Spätestens nachdem ich Houellebeqcs “Serotonin” gelesen hatte, hatte ich für längere Zeit mal genug von männlicher Erweckungsliteratur. Houellebeqc kann gar nicht viel dafür, das war einfach eine Frage der Zeit. Männer erleben irgendwas, haben eine Einsicht, eine Idee – und von dort aus spinnt sich ein Plot, meist Roadmovie-ähnlich, der sonst völlig haltlos wäre. Mit der Erweckung als Rahmenhandlung fällt dann vielleicht nicht ganz so auf, wie haltlos der Plot ist.

Mittlerweile haben Frauen nachgezogen und fabrizieren ähnliche Erweckungstexte. Es sind dann quasi symbolische Roadmovies, die von Druck, Erwartungen und Erkenntnissen handeln.

Der Unterschied: Während männliche Erweckungsprosa Einzeltäter stilisiert, wollen weibliche Gegenstücke oft mitnehmen. Das funktioniert auch nicht immer. Googelt man AutorInnen, die schon länger in diesem Geschäft sind, Sophie Passmann etwa, findet man eine Reihe von Distanzierungen, Entschuldigungen oder Zurücknahmen misslungen ironischer Unterstellungen.

Männer machen sich im übrigen mittlerweile kaum weniger selbstdestruktive Gedanken. Wobei vermutlich zwei wesentliche Unterschiede bestehen: Männer profitieren eher von Nachdenklichkeit – es kann ein Profilierungsmerkmal sein, dass wiederum hilft, Einzeltäter zu stilisieren (womit wir wieder am Anfang sind). Der zweite Unterschied: Männer betrachten diese Art der Selbstverunsicherung eher als destruktiv als Frauen. Wobei Männer weniger ein Problem mit (Selbst)Destruktivität haben; das äußert sich auch in Saufen, Rasen und Extremsport. Damit verstärken neue Verhaltensweisen (wie Selbstreflexivität) alte.

Was hat das mit diesem Buch zu tun? Es ist ein Versuch, Verbindungen herzustellen zu einer Welt, in der die Autorin eine Vielzahl von Therapie- und Massagetechniken erlernt (um sich kennenzulernen), zwei bis drei neue Theorien und AutorInnen pro Seite anreißt und deren Zitate aneinanderreiht und damit Breite und Tiefe herstellt, die nicht wirklich greifbar wird.

Wir alle sind doch mit uns unzufrieden, denke ich mir nach dem Lesen solcher Erweckungstexte immer. Aber wir haben noch nicht alle unser Buch dazu geschrieben.

Michael Hafner

Michael Hafner

Die Welt, aus der wir kommen

Eine entfernte Tante war als junge Frau mit einem deutlich älteren Schotten zusammen, der sehr stolz auf seine Abstammung als – verarmter – schottischer Earl war. Das hatte meine Tante zur Ahnenforschung motiviert. Das Unternehmen endete bei einem unehelich geborenen Sohn einer Magd, der zur Zeit Maria Theresias als Schweinehirt in Niederösterreich lebte. Wenn ich mich nicht irre, hieß er auch Michael.

Die Bauernkriege des 16. und 17. Jahrhunderts verpufften in ihrer politischen Wirkung ähnlich schnell. Sie dauerten auch jeweils nur einige Monate. Ohne die überaus heftige und blutige Reaktion von Adel, Kirche und andere Obrigkeiten hätten sich die Ereignisse vermutlich gar nicht so nachhaltig in der Geschichte verankert. Denn eigentlich waren die Kriege ein Misserfolg. Vor allem der Bauernkrieg von 1525 führte zur Wiedereinführung von Zwangs- und Unterdrückungsmaßnahmen, die erst nach 1848, mit der Unterstützung diesmal oft adliger Revolutionäre aufgehoben wurden.

1525

Lyndal Roper beschreibt den Bauernaufstand 1525, der als plündernde Sauftour durch Klöster begann, schnell zu Gewaltexzessen führte und damit die Rache des Imperiums noch stärker anfachte. Jacob Rohrbach, Kommandant der Weinsberger Bluttat, bei der im April 1525 eine ganze Burgbesatzung hingerichtet wurde, wurde schon im Mai 1525 bei lebendigem Leib verbrannt. Nur eine Woche später wurde Thomas Müntzer, geistlicher Führer der Bauernaufstände, geköpft.

Das beruhigte wohl insgeheim einen von dessen Widersachern: Martin Luther galt mit seiner Reformation als einiger der Väter der Bauernaufstände. Viele Revolutionäre argumentierten mit Luthers Lehre, keinen Herrn außer Gott haben zu wollen. Thomas Müntzer wird als charismatischer Prediger beschrieben, der mit seinen lutherisch inspirierten Predigten Tausende in die Schlacht schicken konnte.

Luther selbst hielt sich aus den Revolutionswirren heraus und distanzierte sich im Verlauf der Kampfhandlungen immer weiter sowohl von den Bauern als auch von Müntzer, um sich schließlich ganz auf die Seite des Adels zu schlagen.

Ropers Erzählung ist eine von vielen Enttäuschungen. Bauern hörten Storys von Gleichheit und Freiheit, von Reformen in der Kirche und von Rechtfertigungsmöglichkeiten vor Gott. Unterdrückerische Grundherren und reiche Klöster waren unbeliebt. Bauern setzen ihre Hoffnungen in höhere Instanzen – göttliche und irdische. Sie richteten Petitionen an Fürsten und Obrigkeiten, boten verarmtem Adel an mitzumarschieren und hielten Brüderlichkeit hoch. Roper weist darauf hin, dass die Betonung von Brüderlichkeit auch einen Ausschluss von Frauen bedeutete. Die waren nicht mitgemeint. Verarmte Ritter marschierten teils freiwillig, teils aus Angst mit. Berühmtester adliger Bauernführer war wohl Götz von Berlichingen, Goethes Ritter mit der Eisernen Hand, der es allerdings eilige hatte, seine Rolle herunterzuspielen, als sich das Glück gewendet hatte.

Vielleicht hatten einige besser gestellte Adlige kurz damit geliebäugelt, die Bauern erst mal machen zu lassen. Klöster plündern und die mächtige Kirche schwächen – das war politisch nützlich. Die Grundherren und den niedrigen Adel beschäftigen – auch das war für einen Fürsten im Sinne von Teile und Herrsche-Strategien nicht grundsätzlich verkehrt.

Mit zunehmendem Erfolg und steigender Gewaltbereitschaft aber kippte die Stimmung, Bauern sahen sich nicht nur von Luther und der Reformation, sondern auch von den Landesfürsten enttäuscht. Die schlugen hart zurück und nützten die Gelegenheit, einige Verschärfungen einzuführen, den Bauern mehr Lasten aufzuerlegen und ihre Situation weiter zu verschlechtern – mit Auflagen, die teils erst nach den Revolutionen von 1848 beseitigt wurden.

Roper nimmt für sich in Anspruch, die Lebenswelt der Bauern zu beschreiben und ausgehend von der Frage, wie es ist, Teil einer Bauernarmee zu sein, zu schreiben. Das gelingt nicht ganz. Die dichten Ereignisse innerhalb kurzer Zeit sperren sich gegen flüssige Dramaturgie. Dennoch ist das Buch allein schon der Materialdichte wegen lesenswert.

1848

Jörg Bong erzählt 300 Jahre später weiter. Bong streut gekonnt Anekdoten in sein breit aufgespanntes Panorama – Richard Wagner protestierte gemeinsam mit Michail Bakunin auf Barrikaden in Dresden, Karl Marx und Heinrich Heine waren Freunde und wie auch Marx’ Frau Jenny waren viele der 1848er Revolutionäre aus gutem Haus oder zumindest reich verheiratet.

Wöhrend die Bauernrevolution von 1525, abgesehen von gelegentlicher Inspiration durch die Reformation, eher eine Grassroots-Bewegung war, war die Revolution von 1848 in Deutschland und Österreich eine Sache der besseren Schichten. Und sie war stark vom aufgeklärten Absolutismus Josef II und von internationalen Beziehungen geprägt. Aus Josef II Leitspruch „Alles für das Volk, nichts durch das Volk“ wurde „Alles für das Volk, alles durch das Volk“ und die Bekannten der Pariser Exilanten rund um Heinrich Heine hielten es nach der Pariser Revolution nur noch für eine Formsache und eine Frage der Zeit, bis die Revolution auch den Rest Europas erreichen würde.

Während sich die Republik in Frankreich zumindest vorübergehend durchsetzte, verlief die Sache in Deutschland um einiges schleppender. Revolutionäre Demokraten versuchten sich lang in Verhandlungen. Die damals sogenannten Liberalen flüchteten sich schnell in den Kompromiss einer konstitutionellen Monarchie. Darin erschöpfte sich der Revolutionsbeitrag der Liberalen – das sollte man im Kopf behalten, wenn heute Burschenschaften und Deutschnationale auf ihre vermeintlich heldenhaften Revolutionsrollen anspielen wollten. Ziel der Liberalen war auch weniger die Demokratie als die Einigung des damals noch in viele Fürstentümer und Königreiche zersplitterten Deutschland; eine Einigung möglichst ohne Österreich, im übrigen.

Zusagen und vage Kompromisse der Obrigkeiten nahmen den Revolutionären in Deutschland viel Wind aus den Segeln, die Kompromissbereitschaft der Liberalen verstärkte diese Lähmungseffekte. Von Struwwelpeter-Erfinder Erinder Heinrich Hoffmann stammt eine zeitgenössische Bart-Typologie für Politiker. Auch dabei unterschieden sich Demokraten und Liberale deutlich. Demokraten trugen Vollbart, Liberale allenfalls Kinnbart, wenn nicht überhaupt nur Lippenbart.

Eindeutig demokratenbärtig waren die heute nur noch wenig bekannten deutschen Revolutionsführer Georg Herwegh und Friedrich Hecker. Herwegh, zu seiner Zeit auch erfolgreicher Dichter, verbrachte viel Zeit in Paris und kehrte hoffnungsfroh zurück, um große Enttäuschungen zu erleben. Wie Friedrich Hecker wollte er sich nicht damit abfinden, dass die Revolution ihr Ende fand, bevor sie eigentlich begonnen hatte. Ein paar Zugeständnisse in der Pressefreiheit und der Abschied Metternichs sollten nicht die einizigen Erfolge bleiben. Sie organisierten von verschiedenen Standorten aus Truppen, die deutsche Regierungsstandorte einnehmen sollten. Es sollten so viele revolutionäre Bauern und Bürger losmarschieren, dass das Militär sie schlicht nicht alle über den Haufen schießen konnte. Es sollten so viele sein, dass niemand die Zahl der Toten, die notwenidg wäre, um diesen Aufstand niederzuschlagen, politisch überleben könnte.

Der Plan ging nicht ganz auf. Herwegh marschierte mit 40 Leuten los. Im Lauf der Zeit wurden es einige mehr, in Summe waren es schließlich mehrere hundert, von denen sich einige wieder verloren, bevor es zu entscheidenden Kämpfen kam. Die Niederlage schließlich war vernichtend, Herwegh und seine Frau entkamen knapp, versteckten sich für einige Tage bei Bauern und schafften es als Landarbeiter getarnt über die Grenze in die Schweiz.

Friedrich Hecker war ein ähnlcihes Schicksal beschieden; die beiden Mini-Armeen trafen nie auf einander, um gemeinsam loszuschlagen. Hecker zog sich wieder nach Frankreich zurück.

Herwegh kehrte nach 1860 nach Deutschland zurück und erlebte noch mit, wie der preußische Prinz, einer der ausdrücklichsten Gegner der Revolution, deutscher Kaiser wurde.

Wilhelm I hatte bis dahin politisch einiges überlebt. Er soll seinem Vater Friedrich Wilhelm III, damlas König von Preußen, zu größter Härte gegen die Revolutionäre in Berlin geraten haben. Die Straßenschlachten müssen blutig und brutal gewesen sein, unter den Opfer waren auch viele Unbeteiligte, die bloß aus ihren Fenstern gesehen hatten oder in Häusern lebten, in die sich Revolutionöre geflüchtet hatten. Überlebende sammelten am Morgen danach die Toten ein und bahrten sie ungewaschen, blutig wie sie waren, im Schloßhof auf. Militär und Wachen müssen von der Zahl der Toten so verunsichert gewesen sein, dass sie nicht einschritten. Sogar der König trat gegen den Rat seines Sohnes vor die Tür, besah das Leichenfeld – und zog seinen Hut.

Das war ausgefeilter politischer Aktionismus von beiden Seiten. Trotzdem gab es kein weiteres Entgegenkommen des Militärs. Und es dauerte weitere 70 Jahre, bis die Monarchien in Deutschland und Österreich ihr Ende fanden.

1626

Für den Oberösterreichischen Bauernkrieg stehen kommendes Jahr einige 400-Jahr-Jubiläen an. Ein Großteil der Literatur zur 1626 ist veraltet und vergriffen. Der Katalog der Oberösterreichischen Landesausstellung zum 350jährigen Jubiälum ist solide 70er-Jahre Sozialwissenschaft in eng gesetztem zweispaltigem Layout. Auch für die Oberösterreicher gilt: Berühmt wurde der Krieg durch die heftige Gegenreaktion, allen voran das Frankenburger Würfelspiel, bei dem 36 Aufständische gegeneinander um ihr Leben würfeln mussten. Die Verlierer wurden gehängt.

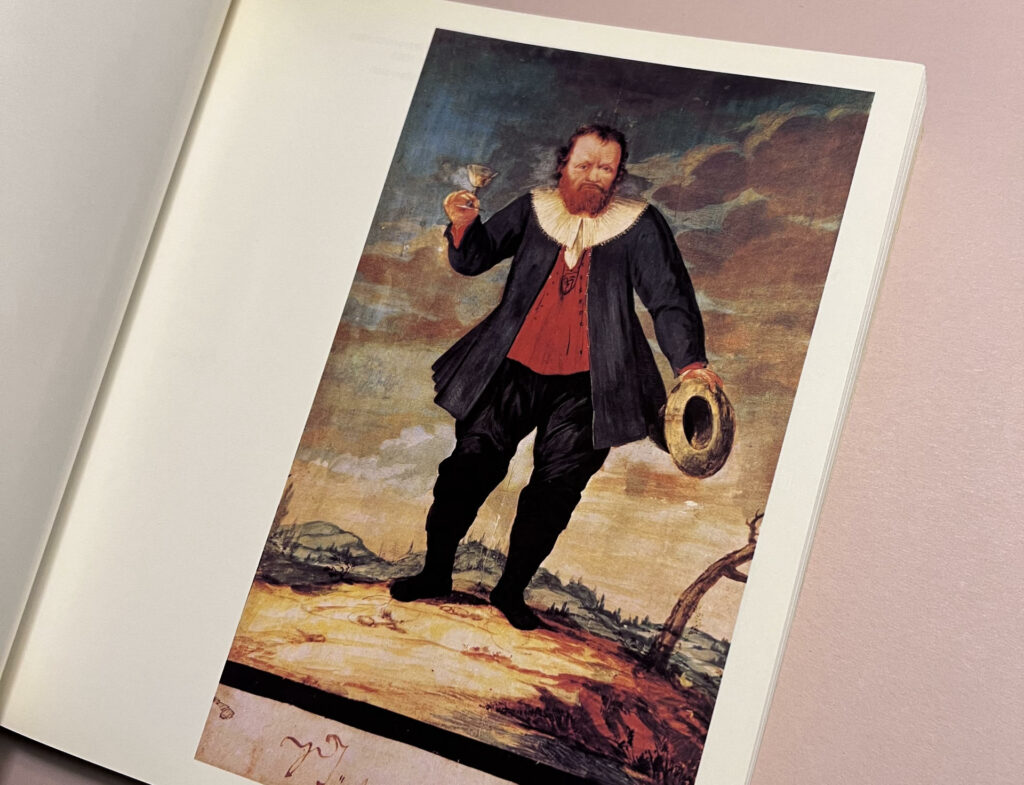

Die Aufstände zogen sich über wenige Wochen und gerade Stefan Fadinger, berühmtester Anführer der Bauernheere, wurde schon im Juli des Jahres erschossen. Die Aufstände kamen nicht aus dem Nichts: Reformations-Streitigkeiten hatten sich über die letzten hundert Jahre gezogen, Ende des 16. Jahrhunderts waren schon nennenswerte Kämpfe aufgeflammt. 1620 hatten die Stände, also die bessergestellten Oberösterreicher den Aufstand geprobt. Oberösterreich war damals an Bayern verpfändet, Adam von Herberstorff, eigentlich ein österreichischer Adeliger, hatte die Sache für den Bayernkönig geregelt und wurde zur Belohnung Statthalter in Oberösterreich.

Diese Konstellation führte wohl auch hier zu einer gewissen Unschlüssigkeit gegenüber den revoltierenden Bauern: Sie waren viele, Städte und Bürger wurden bedeutender, die Bedeutung des Adels nahm ab. Bauern waren Protestanten – so wie es oberösterreichische Adelige zuvor gewesen waren, bevor sie zur Rettung ihres Besitzes zurückkonvertieren mussten. Solange sie Bayernheere bekämpften, war das dem verbliebenen österreichischen Adel gelegentlich nicht ganz unrecht. Oberösterreich hatte um 1620 etwa 300.000 Einwohner, davon war etwa ein Zehntel in den Ständen vertreten. Von diesen 30.000 Personen waren ein gutes Drittel Geistliche, ein knappes Drittel Ritter (also niederer Adel) und das restliche Drittel, Tendenz sinkend, entfiel auf den Herrenstand. Einige Ritter marschierten auch hier mit den Bauern mit – unter Zwang, sagten nachher alle.

Beide Bauernkriege sind trotz der hundert Jahre dazwischen Elemente einer häufig wiederholten Geschichte von oben und unten. Bauern starben zu Tausenden, Adelige Überläufer, die aufseiten der Bauern gekämpft hatten, kamen davon. Nur Achaz Wiellinger, Nachfolger Stefan Fadingers als Bauernhauptmann, wurde auch hingerichtet. Es bestand allerdings Zweifel an der Korrektheit seiner Adelstitel.

General Pappenheim ließ mehrere tausend Bauern abschlachten, auch nachdem der Kampf schon verloren war, und bewunderte anschließend den Mut seiner Gegner. Vermutlich wussten die militärisch unerfahrenen und ungebildeten Bauern gar nicht, dass es auch eine Option gewesen wäre, sich zu ergeben.

Vielleicht sind die Verhältnisse heute etwas einfacher. Trotzdem wirkt noch vieles nach – auch die Frage, auf welcher Seite der Revolution man sich zuhause fühlt.

Most-Voodoo

Eine neue Entdeckung in den Bauernkriegs-Dokumentation war für mich der weit verbreitete Aberglaube auch in militärischen Dingen. Bauern hatten Zaubertränke, aßen kleine Zettel mit Hexensprüchen von der Schlacht und sangen Schlachtlieder, die Schuss-. Hieb- und Stichfestigkeit bewirken sollten. Stefan Fadinger galt als unverwundbar (und starb, gemessen an dieser Zuschreibung) ziemlich schnell.

Trotzdem waren sich die fürstlichen und kaiserlichen Truppen nicht so sicher. Soldaten antworteten, in dem sie in die Kugeln ihrer Gewehre Zeichen ritzten, die diesen Unverwundbarkeitsbann brechen sollten.

Rund um diese Ideen schlossen sich noch in den nächsten hundert Jahren viele Zauberer- und Hexenprozesse an. Berühmt wurde die Kaperger Bande. Ich denke, ich muss da weiterlesen …

Tsitsi Dangaremba: Schwarz und Frau

Es gibt Bücher, die kann man als alter weißer Mann tatsächlich nur zur Kenntnis nehmen. In “Schwarz und Frau” beschreibt Dangaremba Hindernisse und Hürden auf ihrem Weg als schwarze Frau vom Pflegekind zur prominenten Autorin. Prägend sind Erfahrungen als Pflegekind in einer weißen christlichen Familie in Simbabwe. Simbabwe hat als ehemaliges Rhodesien eines der ausbeuterischsten Kolonial-Terrorregime hinter sich. Dangaremba wurde von ihren Eltern, die Ausbildungen in England absolvierten, in Pflege gegeben. Unkonventionelle Erzählstile und Dramaturgien entsprachen nicht dem Curriculum der Creative Writing-Klassen im College.

Unbestritten: Europäische Aufklärung ist voll von Rassismus, absurden Gender-Theorien und imperialistischen Ansprüchen. Weiße Europäer haben in den vergangenen 500 Jahren vielen Menschen im Süden und anderen neuen Welten das Leben zur Hölle gemacht.

Es ist aber doch etwas zu kurz gegriffen, die Geschichte von Ausbeutung und Imperialismus erst mit dem Römischen Imperium beginnen zu lassen und sie damit auf Europa einzugrenzen. China? Osmanen? Dangaremba selbst erzählt anekdotisch, dass römische Imperialisten in ihrem Imperiumsdünkel die eben unterworfenen Briten als wilde rückständige Untermenschen beschrieben. Konnte der Brite, Inbegriff des weißen Herrenmenschen der afrikanischen Kolonialzeit, Opfer von Rassismus und Imperialismus sein?

Einige Thesen taugen, wie öfters im identitätspolitischen Umfeld, einigermaßen als Diagnose, aber wenig als Handlungsempfehlung. Progressiver Separationismus, Standpunkttheorie und ähnliche Positionen helfen vielleicht bei der Problemfeststellung, aber nicht bei dessen Behebung.

Manchmal drängt sich auch die Frage auf, ob die Diagnose treffend ist – oder wie weit die Verknüpfung eines allgemeinen „Unbehagen in der Kultur“ (das auch ein anderer alter Mann beschrieben hat) mit spitzen Perspektiven zu mehr als persönlicher Erkenntnis führt. Den Wert dieser Erkenntnis zu beurteilen möchte ich mir nicht anmaßen.

Yascha Mounk: Im Zeitalter der Identität

Es ist ärgerlich, wenn Cancel Culture, PoMo-Politik oder eben Identitätsrants mit Foucault beginnen. Foucault war vermutlich kein angenehmer Mensch, eher problemverliebt als lösungsorientiert und durchaus auf die passende Pose bedacht, es wäre aber grobes Unrecht, ihm irgendeine Art des Hangs zum Universellen unterstellen zu wollen. Es ist der Kern von Foucaults Arbeit, sich gegen Essenz, Substanz, Wesen und andere Vorstellungen einer letzten, „hinter den Dingen“ liegenden Objektivität oder Wahrheit auszusprechen. Dabei ist Foucault nicht einmal Relativist. Er beschränkt sich auf die Analyse dessen, was wir für unser Verständnis heranziehen können und unterscheidet es von dem, über das zu spekulieren sinnlos wäre.

Gegen Ende seines Buches räumt Mounk das auch ein. Dennoch ist es ein wenig ärgerlich, in den ersten Kapiteln zu suggerieren, es ließe sich eine direkte Linie von Foucault, Lyotard oder Derrida zu den Auswüchsen aktueller Identitäts-Absolutismen ziehen. Beispiele für solche Absolutismen finden sich in akutellen Rasse-, Postkolonialismus- oder Transgender-Theorien.

Auch frühe postkoloniale AutorInnen werden von Mounk nicht ganz fair in die Ahnenreihe von PoMo-Identitären IdeologInnen gestellt. Edward Said verwehrte sich ganz entschieden gegen jedweden Essenzialismus, der obskure Faszination für das Orientalische schaffte und Menschen aus dem Orient von Personen zu Ausstellungsstücken in europäischen Salons verwandelte.

Gayatri Spivak bezeichnete ihren Essenzialismus ganz ausdrücklich als strategischen Essenzialismus und distanzierte sich später noch davon.

Dekonstruktion und philosophische Postmoderne sind keine gute Basis für konstruktive Kritik, sondern eben das Ende eine an sich nicht besonders konstruktiven Diskussion. Das macht Dekonstruktion als Methode nicht falsch, aber auch nicht unbedingt nützlich. Dekonstruktion kehrt Grundlagen und Funktionsweisen, die gern übergangen werden, nach außen, zerlegt sie, nimmt Begriffe und Ideologien auseinander. Dabei geht Dekonstruktion nicht vor wie jemand, der das alte Radio noch mal zusammenbauen möchte, auch wenn er es nicht reparieren kann, sondern eher wie jemand, der sich von dem Gerät schon verabschiedet hat, aber dennoch wissen möchte, wie es innen aussieht, bevor es auf dem Recyclinghof landet.

Dekonstruktion liefert keine Handlungsanleitungen. Aber Dekonstruktion vermittelt Wissen und schafft die Grundlage, sich frei für andere Wege zu entscheiden. Dekonstruktion schafft die Freiheit, alle möglichen Entscheidungen zu treffen. Aber sie liefert keine Mittel und Argumente, eine Entscheidung zu rechtfertigen oder über andere zu stellen. Das ist eines der großen Missverständnisse, wenn frühe Postmoderne herangezogen wird, um aktuelle Essenzialismus- und Absolutismus-Auswüchse zu kritisieren.

Ähnlich verhält es sich mit Standpunkttheorie und anderen um Differenzierung bemühten Methoden. Man sieht die Welt anders, wenn man sie von einem anderen Standpunkt aus betrachtet. Dass man Menschen nicht verstehen kann, die mit einem anderen Standpunkt aufgewachsen sind, ist Unsinn – wozu auch sollte man ihnen denn dann zuhören? Eine solche Interpretation der Standpunkttheorie ist absurd.

Beide, Standpunkttheorie und Dekonstruktion und viele andere kritisierte Theorien sind Diagnosewerkzeuge, keine Handlungsanleitungen, keine moralischen Prinzipien und politischen Paradigmen.

Mounk arbeitet sich trotzdem daran ab. Das ist die Schwäche dieses Buchs.

Die Stärke ist der Schnelldurchlauf durch allerhand zeitgenössische Rasse-, Klasse-, Gender- und Kolonialismuskonzepte, die allesamt ähnliche Karrieren von guten Diagnosen zu schlechten Handlungsanleitungen durchlaufen haben.

Tragisch ist vor allem die Karriere des Free Speech-Begriffs. Rede- und Meinungsfreiheit, eines der zentralen Anliegen frühbürgerlicher Revolutionen, dann Prunkstück jeder Demokratie, später Toleranzgrenzen herausforderndes Sorgenkind und von Rechten missbrauchte Tarnung für verlogene Ideologiepropaganda, ist heute ein Feindbild, dem unterstellt wird, in Diensten Konservativer zu stehen. Das ist nicht ganz von der Hand zu weisen, wenn man sich vor Augen hält, wer am lautesten „Das wird man doch noch sagen dürfen!“ ruft. Dennoch ist es eine der erschreckendsten Entwicklungen unserer Zeit, wie schnell sich jüngere Menschen mit Kontrolle, Überwachung und Verboten (für andere) anfreunden.

Progressiver Separationismus als als Förderung verstandene neue Rassentrennung, Trans vs. Feminismus-Kämpfe und neuer Klassenkampf sind weitere Beispiele dafür, wie aus guten Diagnosen schlechte Handlungsempfehlungen wurden. Allesamt können sie sich auf ein neues Feindbild einigen: Feind der neuen Rasse-, Klasse- und Gender-Essenzialisten ist der Liberalismus.

Liberalismus, der eigentlich nur alle sein lassen wollte, wie sie sind, ist zu wenig supportive. Liberalismus kritisiert die Vorstellung, dass etwas so sein sollte und nicht anders sein darf. Das verträgt sich schlecht mit der Idee, dass Identitäten sich zwar aus verschiedensten Elementen zusammensetzen, aber dennoch unhintergehbar prägende Merkmale unserer Menschlichkeit sind, denen wir ausgeliefert sind. Man müsse Identität an erste Stelle stellen, um gute Entscheidungen treffen zu können, und die Betonung bislang unterdrückter Identitäten aus Kosten der ehemaligen Unterdrücker sei wichtiger als altmodische Unterstellungen von Freiheit.

Mounk setzt nach seiner Ausarbeitung dieser Auswüchse zu einem Plädoyer für den Liberalismus an – aber er bringt nur schwache Argumente, die Wasser auf die Mühlen linksidentitärer Essenzialisten sind. Es ist ja eben die Tragik des Liberalismus, dass Argumente, die sich an jene richten sollten, die Liberalismus ablehnen, genau diese überhaupt nicht interessieren – oder eben ihre härtesten Kritikpunkte sind.

Liebralismus ist aus Prinzip ein schwaches Argument.

Was sich gegenüber grassierendem Identitätsessenzialismus durchsetzen müsste, ist die Einsicht, dass ähnlich wie im Fall von Dekonstruktion und Postmoderne, die Diagnose vielleicht stimmt. Aber die Werkzeuge, die zur Diagnose geführt haben, liefern denkbar schlechte Handlungsanleitungen.

Niall Ferguson: The Great Degeneration

Mit dem Westen geht‘s bergab – an der Diagnose hat sich wenig verändert, trotzdem meinte Ferguson beim Erscheinen von „The Great Degeneration“ 2012 etwas anderes damit, als man heute darunter verstehen würde. 2012 war Migration noch kein dermaßen dominantes Thema, China schien in einer unaufhaltsamen Aufwärtsbewegung, die Krim gehörte unbestritten zur Ukraine und die USA hatten noch nicht einmal die erste Trump-Präsidentschaft hinter sich. Wie schnell solche Bücher jetzt veralten.

Fergusons Degenerationsdiagnose ist handfest: Der Westen hatte einen Vorsprung, inklusive Institutionen (hier stimmt Ferguson Acemoglu und Robinson zu) haben dazu beigetragen, diesen Vorsprung zu ermöglichen, in entscheidenden Bereichen wie Wohlstand und Bildung aber stagniert der Westen, während andere Teile der Welt deutlich aufholen.

Institutionen haben Sicherheit geschaffen, die dadurch entstandene Stabilität hat Wachstum ermöglicht. Wesentlicher Zusammenhang für diese Entwicklung ist die Möglichkeit, Schulden zu machen: England als einer der am frühesten für breitere Bevölkerungsschichten stabile Staaten war ein vertrauenswürdiger Schuldner – mehr Menschen besaßen Land, konnten wirtschaften und Steuern zahlen. Das ermöglichte es dem Staat, Schulden aufzunehmen das ergab eine gut gefüllte Kriegskasse, mit der sich See- und Kolonialkriege führen ließen.

Stagnierende Wirtschaft gefährdet dieses Zusammenspiel und macht Schulden zu einem Problem. Von langsamer Wirtschaft und hohen Schulden betroffene Staaten müssten sich zwischen Reformen und dem Schicksal Griechenlands (also späteren, aber umso einschneidenderen Reformen) entscheiden, würden aber eher versuchen, dem Risiko hoher Schulden mit möglichst niedrigen Zinsen zu begegnen. Das ist schlecht für das Wirtschaftswachstum und das Inflationsrisiko. Heute, gut zehn Jahre später, wissen wir das – auch wenn es mit einer Pandemie und einem Krieg noch weiterer Anstöße bedurft hat, das Inflationsrisiko schlagend lassen zu werden.

Drohende Risiken ziehen Regulierungen nach sich, in den Nachwehen der Finanzkrise (die 2012 noch präsenter waren) waren insbesondere Banken steigender Regulierung ausgesetzt. Ferguson schätzt stabile Institutionen, kritisiert aber Regulierung. Stattdessen appelliert er an Verantwortung. Deregulierung sei weniger ein Problem als das Gefühl von Straflosigkeit, das sich ausbreite, wenn Bankbosse auch in Krisen noch Boni kassierten.

Das ist eine etwas moralisierende Vorstellung. Welche Anreize (abgesehen davon, Strafen zu entgehen) zu mehr Verantwortung führen sollten, lässt Ferguson offen. Ebenso unklar bleibt, auf welcher (Management)Ebene Verantwortung eingefordert und Konsequenzen durchgesetzt oder Initiative honoriert werden sollten. Aktuelle Organisationen dienen eher dazu, Verantwortung zu verdünnen.

Ferguson beschreibt ähnliches anhand eines kurz gestreiften Vergleichs zwischen englischer und französischer Rechtsgeschichte. Frankreich habe nach der Revolution aus Misstrauen gegenüber Autoritäten sehr detaillierte Gesetze erlassen, die Richtern Spielraum nehmen und sie zu Automaten machen sollten. England dagegen habe auf das Prinzip „mind your own bloody business“ gesetzt und nur das notwendigste geregelt.

Das ist nachvollziehbar, Fergusons andere Belege für positive Entwicklung durch weniger Regulierung ist allerdings durchaus fragwürdig. Er zieht etwa den Doing Business Index heran. Im Spitzenfeld dort liegen Ruanda und Belarus, beides keine Leuchttürme bürgerlicher Freiheiten. Auch Georgien oder Mazedonien, beide in den Top Ten weltweit, sind keine Paradebeispiele guter Governance. Die Liste löst eher Kopfschütteln aus – und das liegt nicht am Alter dieses Buchs.

Regulierung und Stagnation sind für Ferguson in einer ungesunden Wechselbeziehung, ein weiterer Faktor ist seiner Ansicht nach die Schwächung der Zivilgesellschaft durch den Rückgang bürgerlichen Engagements in Vereinen, Clubs, Parteien oder Charities. Mit Tocqueville macht der den fürsorglichen Staat dafür verantwortlich: Bürger erwarten heute mehr vom Staat, der sich damit in mehr Dinge einmischt, mehr aus weiterer Ferne mit weniger Kompetenz regelt, als zivilgesellschaftliche Initiativen das könnten, und so dafür sorgt, dass Bürger Selbstständigkeit verlernen.

Das mag zum Teil zutreffen. Diese Einschätzung setzt aber ebenfalls eine moralisierende Einstellung voraus, in der Bürger Verantwortung übernehmen wollen und sollen – während offenbleibt, was dann eigentlich die Aufgaben des Staates sind, der finanziell gut ausgestattet ist und von seinen Bürgern dafür bezahlt wird, Dinge zu regeln. Und zwar auch für die, die nicht mitzahlen können. Zivilgesellschaftliches Engagement wird schnell zum Almosen und schafft Unsicherheit für jene, die darauf angewiesen sind. Unsicherheit kann auch ein Ansporn sein, sich daraus zu befreien und sein eigenes bloody business zu regeln. Die Erfahrung der letzten Jahrzehnte hat anderes gezeigt, und hier müssten sehr viele Stellschrauben gut aufeinander abgestimmt sein, um einen Ausweg zu ermöglichen.

Technik sieht Ferguson auch nicht als Lösung. Seine Perspektive auf Technik wirkt wie aus dem Industriezeitalter, er bezweifelt das ökonomische Potenzial (vor allem digitaler) Technologie. Das ist insofern ein Irrtum, als der ökonomische Aufstieg von Digitaltechnologie bislang rasant war und digitale Technologie es überdies geschafft hat, Grundsätze des Industriekapitalismus und des frühen Digitalkapitalismus hinter sich zu lassen: Produkte müssen lange keinen Nutzen mehr stiften, um rasantes Wachstum zu bringen. Sie müssen sich nur gut dazu eignen, in Lock-in-Geschäftsmodelle verpackt zu werden, aus denen User nicht mehr auskommen. Ferguson vermisst Nutzen in der Silicon Valley Euphorie der frühen 10er Jahre – das mag stimmen, tat aber dem Wachstum keinen Abbruch. Und gänzlich etwas verstörend ist Fergusons Referenz für Kritik an Tech-Ideologie: Er sieht ausgerechnet in Peter Thiel einen nüchternen Kritiker des Wachstums-Innovations-Disruptionskultes. Das ist wohl eine dramatische Fehleinschätzung.

Dem Westen geht es nicht gut, das ist klar. Fergusons Perspektiven sind aber eher nicht Teil der Lösung.

Douglas Rushkoff: Survival of the Richest

Tech-Milliardäre und andere Gallionsfiguren angkündigter digitaler Revolutionen sehnen sich in den Mutterleib zurück und bauen sich mit digitalen Räumen Simulationen dieser geschütztesten aller Umgebungen, in der ihnen nichts Böses widerfahren kann. Das ist eine der Thesen des bekennenden Marxisten Rushkoff in seiner Kritik digitaler Machbarkeitsphantasien. Ausgangspunkt seines Buchs ist eine Unterhaltung mit Milliardären, die Beratung beim Bau geschützter Umgebungen zum Überleben des “Ereignisses” suchten.

Das “Ereignis” kann eine fatale Pandemie, ein Nuklearkrieg oder sozialer Flächenbrand sein. Rushkoffs Kritik an der Frage: Selbsternannte Macher beschäftigen sich nicht mehr mit der Suche nach Lösungen (von Problemen, die oft ihre Innovationen geschaffen haben), sondern damit, wie sie drohenden Konsequenzen ausweichen können. Rushkoff nennt das das “Mindset”: Das Mindset beschreibt die Einstellung, Innovation und Disruption am Fließband produzieren und in Geschäftsgelegenheiten verwandeln zu wollen, technische Lösungen für alles zu suchen und Lösungen vor allem in der Erstellung neuer Produkte zu sehen. Das Mindset optimiert – dafür strukturiert es alles nach seinen Bedürfnissen und ignoriert, was nicht angepasst werden kann.

Der moderne Businesscase, beobachtet Rushkoff treffend, funktioniert wie eine streng nach dem Heldenreise-Schema gestrickte Erzählung mit Klimax und Katharsis. Übersteigerte und als essenziell dargestellte Probleme, die bislang niemandes Problem waren, werden zur Schicksalsfrage der Menschheit und schließlich einer überzeugenden Lösung zugeführt. TED Talks sind eine weitere Ausprägung dieser formalistischen Inszenierungen, in denen Inhalte recht beliebig ausgetauscht werden können. Religion und Leitprinzip dieser Inszenierungen ist vereinfachter Behaviorismus, der Menschen zu Reaktionsautomaten reduziert, die von der erweckten Businessperson gesteuert werden können.

Peter Thiels Ausführungen sind hier die prägendsten; wer Thiel nicht im Original lesen möchte, findet einen guten Überblick bei Adrian Daub.

Der technikorientierte und oberflächlich extrem rationale Schematismus zielt darauf ab, Abläufe als notwendig, effizient, sinnvoll und einem höheren Ziel folgend darzustellen. Die eigentliche Leistung dieses Konstrukts ist es aber, die real im Hintergrund stattfindende Arbeit unsichtbar zu machen. Rushkoff vergleicht das mit der Erfindung des Speiseaufzugs im Haus von Thomas Jefferson: Die Entlastung des Hauspersonals war der kleinste Schritt, die hatten schon viel geschleppt, bevor sie den Speiseaufzug befüllten. Der nahm ihnen nur das letzte Stockwerk ab und reduzierte den Personalbedarf im Speisezimmer bei den leichten Arbeiten.

Der vermeintliche hyperrationale Homo Oeconomicus ist schon länger als Chimäre in Verruf. Rein vernunftorientierte Ansätze, die die Hartnäckigkeit realweltlicher Probleme ignorieren, bieten eindimensionale Lösungen, die tatsächlich erst zu Lösungen erklärt werden müssen. Sonst käme niemand auf die Idee, sie als Lösungen zu betrachten. Die Eindimensionalität dieser Ideen findet sich auch in der Kritik der modernen Wissenschaftstheorie; am wenigsten unter Schwurbelverdacht (für Postmoderne-Phobiker) ist hier wohl David Bloor.

Der moderne Elite-Kapitalist ist ja durchaus für Alternativen offen und experimentiert mit Ayahuasca oder anderen Kaktus- und Krötengiften, um seinen Horizont zu erweitern. Rushkoff beschreibt einige nach Ayahuasca-Experiences entstandene Businesspläne und wundert sich zurecht, wie leer die innere Welt der Erleuchteten vorher gewesen sein muss, wenn sie diese Ideen nur unter psychedelischen Einflüssen entwickeln konnten.

Für die Innovativen, Techsmarten und Erfolgreichen sind diese Einwände kein Hindernis. Das zeigt alljährlich die erstaunliche Selbstzufriedenheit in Davos oder Alpbach: Die gleichen Menschen besprechen jedes Jahr die gleichen Themen, finden die gleichen Ideen gut, feiern produktive und inspirierende Gespräche – und treffen einander doch im nächsten Jahr bei großteils dem gleichen Stand der Dinge wieder, um einmal mehr das gleiche zu besprechen und die gleichen Ideen (die schon die letzten Jahre im Sand verlaufen sind) zu feiern.

Was als Philanthrokapitalismus begann (reiche Menschen wie Bill Gates setzen ihr Vermögen für ein paar gute Zwecke ein und versuchen, zumindest selbsterhaltende Geschäftsmodelle zu etablieren) ist zur Legitimation extraktiver Institutionen geworden: Eine dünne Tech- und Businesselite gibt “Lösungen” vor, die vermeintlich die Probleme der Welt lösen. Tatsächlich muss sich die Welt an diese Lösungen anpassen, damit überhaupt die zu lösenden Probleme existieren. Dann funktioniert auch das Geschäftsmodell der Tech-Elite. Extraktive Institutionen sind, wie Acemoglu und Robinson ausführen, ein wesentlicher Grund, warum Nationen und Organisationen scheitern.

Werden also technische Eliten Probleme lösen? Nein, sagt Rushkoff, sie haben sie eher verursacht und tragen durch ihre Lösungsansätze dazu bei, dass sie bestehen bleiben. Vielleicht wird ja auch KI, sofern sie eines Tages eigene Gedanken fasst, das Mindset ihrer Erfinder übernehmen und versuchen, sie wie das Bedienpersonal eines Speiseaufzugs unsichtbar zu machen.

Brendan Ballou: Plunder

Investmentbanken, früher der Gottseibeiuns des Heuschreckenkapitalismus, unterliegen seit der Finanzkrise von 2008 einigermaßen strengen Regeln. Damit sind die fragwürdigen Geschäfte, die Subprime Crash und Finanzkrise herbeigeführt haben, nicht verschwunden. Die Geschäfte macht jetzt nur jemnand anderer. Privates Kapital füllt die Lücke, die der Rückzug der Banken eröffnet hat. Private Equity, also Kapital, das abseits öffentlicher Börsen Unternehmensbeteiligungen sammelt, unterliegt wenigen Regeln, lebt vom Ausnutzen von Gesetzes- und Steuerschlupflöchern und vom Tempo. Unternehmen, an denen Private Equity-Konzerne Beteiligungen erworben haben, werden restrukturiert, oft in Franchisesysteme verwandelt, in Sell&Lease Back-Modelle gedrängt oder dazu gezwungen, Dienstleistungen oder Lieferungen von anderen zum gleichen Private Equity-Konzern gehörenden Unternehmen zu beziehen. Das verwandelt florierende Unternehmen schnell in Pleitekandidaten, das senkt die Servicequalität für Kunden und das begünstigt die Entstehung von Geschäftsmodellen, die auf leicht ausbeut- und erpressbare Kunden angewiesen sind. Nicht umsonst floriert das Private Equity Business stark in Pflegeeinrichtungen, in denen Personal reduziert wird, oder in Gefängnissen, in denen die Qualität der Ernährung herabgesetzt wird oder Insassen gezwungen werden, für simple Dienstleistungen wie Telefonanrufe horrende Preise zu bezahlen.

Brendan Ballou war auf Private Equity und Kartellrecht spezialisierter Staatsanwalt in den USA und auch in die Ermittlungen gegen die Kapitol-Stürmer involviert. Das ist leider auch schon das Spannendste an diesem Buch. „Plunder“ ist eine etwas uninspiriert dahinerzählte Sammlung von Aufregern, deren Menge eher abstumpft als sensibilisiert.

Aufregend sind die auf dem Spiel stehenden Beträge, die schnell in Milliardenhöhen schnellen und von Europa aus absurd fantastisch wirken. Das Buch schließt mit einer 30seitigen Aufzählung von Gesetzes- oder Steuerlücken, die geschlossen werden müssten, um Private Equity in geregelte Bahnen zu lenken. Im Kontext von zahlreichen anderen Regulierungsdebatten ist das eine richtungsweisende Sammlung, aber sie verliert sich ein wenig in der Vielfalt der behandelten Themen. Private Equity-Geschäftsmodelle sind ein Aspekt mehr, der für den Nutzen Weniger Nachteile für Viele bringt und nicht einmal ansatzweise Mehrwert stiftet. Das ist ein Muster, das heute oft zu beobachten ist und das teilweise astronomische Verschiebungen bewirkt. Ballous Erzählung bleibt aber blass, arbeitet keine Trends und Muster heraus – und stammt außerdem aus der Ära vor Trumps zweiter Präsidentschaft, die noch einmal alles über den Haufen wirft und nachteilige Entwicklungen beschleunigt. Sozial- und politkritische Bücher aus den USA altern zur Zeit besonders schnell.

Anu Bradford: Digital Empires

Das Internet ist nicht mehr global. Diverse Internetvarianten stehen einander gegenüber, bekämpfen einander teilweise, suchen mit verschiedenen Mitteln Vorherrschaft und Marktmacht und konkurrieren um Einfluss in noch unentschiedenen Märkten. Anu Bradford beschreibt, wie unterschiedliche Formen von Digitalpolitik in den USA, in China und in der EU unterschiedliche Prioritäten setzen. Ihre Schlussfolgerung ist geradezu versöhnlich: Europa werde sich durchsetzen, denn auch in den USA mache sich zunehmend Kritik am rein marktorientierten Governancemodell breit, die überbordende Macht der Techkonzerne werde kritisch betrachtet und es gebe mehr und mehr Bereitschaft, auch von den USA aus Technologie und Digitalmarkt in Regeln zu fassen.

Das Buch erschien 2023, bevor sich abzeichnete, dass eine zweite Trump-Präsidentschaft Realität werden könnte.

Der Sturm auf das Kapitol vom Jänner 2021 ist eines der Beispiele, das auch den USA die politische Macht und Gefahr digitaler Politik vor Augen geführt habe. Der Großteil der von Biden verabschiedeten Digitalregelungen ist schon wieder – im ersten Monat von Trumps Regierungszeit – außer Kraft gesetzt. Die von Bradford nur kurz als absurd gestreifte Option, die USA könnten sich auf die digitale Seite Chinas und damit Russlands stellen, ist dabei, Realität zu werden.

Die Diagnose dieses Buches steht damit auf wackligen Beinen, die Analyse ist umso relevanter.

Bradford beschreibt das US-Internet-Governance-Modell als marktorientiertes und freiheitsbetontes, das staatliche Einmischung vermeide und Regeln als Innovationshürde betrachte.

Gegenpol dazu ist das chinesische Modell, das Staat und Partei an erster Stelle sieht, Innovation an staatliche Vorgaben und Programme bindet und massiv in Märkte und Geschäftsmodelle eingreift, um mögliche Fehlentwicklungen zu korrigieren.

Europa verfolgt ein rechtegetriebenes Modell, in dem Daten- und Konsumentenschutz im Vordergrund stehen. Damit kommen weniger eigene Innovationen in den Markt, aber Europa gibt vor, nach welchen Regeln Innovation in den Markt kommt. Denn solange Europa ein interessanter Markt für globale Unternehmen ist, sind diese bereit, Auflagen zu erfüllen.

Bradford nennt diese Dreiteilung die horizontale Seite des Kampfs um digitale Vorherrschaft. Dazu kommt die vertikale Dimension, in der einander Staaten, Unternehmen und Zivilgesellschaft gegenüberstehen.

Das freiheitsorientierte Digitalmodell der USA basiert teilweise auf veralteten Voraussetzungen. Die Section 230-Regel, die Betreiber digitale Dienste weitestgehend von der Verantwortung für Inhalte freispricht, stammt aus den Neunziger Jahren. Damals waren Dienstebetreiber vorrangig Provider, die Server und Leitungen zur Verfügung stellten und tatsächlich nichts mit Inhalten zu tun hatten. Das hat sich deutlich verändert. Eine andere Schwäche des digitalen Freiheitsgedankens: Die USA halten sich selbst nicht daran. Aufgedeckte Überwachungs- und Spionagefälle zeichnen ein anderes Bild als das des vom Staat unberührten Internet. Und um kritische Märkte zu erschließen, werden die Freiheitsprinzipien ebenfalls flexibel gehandhabt. Apple macht 20 Prozent seines globalen Umsatzes in China, hat dazu eine eigene, kontrollierte Appstore-Instanz ins Leben gerufen und lagert die Daten chinesischer Nutzer in einem chinesischen Datawarehouse, dess Betreiber im Zugriff der chinesichen Regierung steht. Microsoft hat noch vor dem Ausbruch des Ukraine-Krieges russische Cyberattacken auf ukrainische Behörden-Netzwerke registriert und Regierungen informiert. Die USA treffen damit auf öfters auf Kritik. Ein Kritikpunkt betrifft Scheinheiligkeit und Glaubwürdigkeit, ein andere die Skepsis von Staat gegenüber digitalen Freiheit.

Beides spielt letztlich dem chinesischen Modell in die Hände. Autokraten aller Größenordnungen in Europa, Afrika und Asien sind gegenüber Möglichkeiten, das Internet strikt zu regulieren, durchaus aufgeschlossen. Wo Staatsinteressen im Vordergrund stehen, sollen Einzelinteressen kontrolliert und zurückgedrängt werden können. China bietet dafür Infrastruktur, Überwachungstechnologie und Governancemodelle, die auch die stärksten Unternehmen klein halten. Die Kommunistische Partei verhängt Milliardenstrafen gegen börsenotierte Konzerne, ordnet Merger oder Aufteilungen an und verbietet chinesischen Konzernen Börsegänge in den USA, wenn dafür Daten offengelegt werden müssten. Alibaba-Gründer Jack Ma ist Parteimitglied. Soziale Harmonie ist die Keule, mit der Abweichungen wieder eingefangen und notfalls eingestampft werden. Der Sturm auf das US Kapitol im Jänner 2021 sei in chinesischen Medien ein Paradebeispiel dafür, was passiere, wenn digitale Medien nicht im Sinne der Gemeinschaft kontrolliert würden. Zensur und Medienkontrolle funktioniert sehr gut – vor allem auch, weil Jahrzehnte von Zensur und kontrollierten Medien dazu geführt haben, dass Menschen den Umgang mit Medien und Information verlernt haben. China gibt strenge Regeln vor, sperrt andere aus dem chinesischen Markt aus, drängt selbst aber sehr aktiv auf andere Märkte.

Bei der Einschätzung der Capitol Riots treffen einander China und Europa, allerdings von verschiedenen Seiten. In Europa stehen Bürgerrechte im Vordergrund, nicht der Staat. Das prägt die Digitalgesetzgebung – und das bringt Europa den Ruf ein, Innovation durch Regeln abzuwürgen. Diesen Einwand betrachtet Bradford allerdings skeptisch. Auch vor der DSGVO, der ersten großen und tiefgreifenden Digitalregelung, sei wenig erfolgreiche Innovation aus Europa gekommen. Relevanter seien Probleme wie Sprachbarrieren, fehlende Regelungen für einen einheitlichen Binnenmarkt und der Umgang mit unternehmerischem oder finanziellem Risiko. Überdies seit die EU-Verwaltung, die nur ein Prozent des EU-BIP ausmache, deutlich kleiner dimensioniert als die US-Verwaltung, die 20 Prozent des US-BIP verschlinge. Europäische Regulierung wird als innovationsbremsend, protektionistisch und revanchistisch gegen erfolgreiche US-Konzerne kritisiert. Allerdings verfolgen europäische Regulierungen auch marktverzerrende Förderungen – und richten sich damit auch gegen staatliche Einflussnahme auf den Digitalmarkt.

Was Europa laut Bradfords Analyse zugutekommen kann, ist ein stärker aufkeimendes Bewusstsein um die Relevanz digitaler Souveränität. Die USA verfolgen dieses Ziel mit Macht- und geldorientiertem Imperialismus, China setzt auf Infrastrukturimperialismus, die EU hält mit Regulierungsimperialismus dagegen. Nur letzterer steht allen Staaten offen. Bradford bezeichnet es als Brussels Effect, wenn sich auch Staaten und Unternehmen, die das gar nicht müssten, an EU-Prinizipien orientieren. Das geschieht einerseits aus politischen Gründen, um demokratische Einflussnahme zu sichern, andererseits aus wirtschaftlichen: Wenn Unternehmen strenge EU-Auflagen erfüllen, um in der EU operieren zu dürfen, wenden sie diese Grundsätze überall an, weil das oft effizienter ist, als unterschiedliche Standards und Regelsysteme zu verwalten. Damit gewinnt insgesamt Europa wieder ein wenig Oberhand – zumindest so lange, wie sich US-Konzerne nicht ausdrücklich gegen die EU stellen. Letzteres zeichnet sich gerade ab.

China betreibt neben seinem Infrastrukturimperialismus, der als neue Digitale Seidenstraße Technologie, Infrastruktur, chinesische Standards, in Hard- und Software verbaute chinesische Grundsätze und chinesische Überwachungstechnologie exportiert, noch eine zweite Strategie. Es ist großteils Folge chinesischer Initiative, dass Digitalthemen in den letzten Jahren jetzt auch stärker auf UN-Ebene verhandelt und reguliert werden. Das entzieht die Digitalgesetzgebung ein Stück weit dem Einfluss von EU und USA, das erhöht staatlichen Einfluss dort, wo bislang zivilgesellschaftlich verwaltet wurde, und das schafft eine neue Bühne, auf der Staaten auf eine multipolare Welt pochen können, die nicht nur vom Westen geprägt werden soll, auf der man sich Einmischung in innere Angelegenheiten verbitten kann und die Platz für flexible Interpretationen von Menschenrechten bietet. Letzteres ist eine beliebte Diskursstrategie von Autokraten. Russland gefällt das. Und die Entscheidungen zu UN Global Digital Compact und UN Cybercrime Convention dokumentieren das.

Diese schleichend autoritäre Tendenz in UN-Digitalpolitik, das Kippen der USA und der großen US-Techkonzerne, die Annäherungen zwischen den USA und Russland, der Erfolgslauf chinesischer Technologie und die Schwäche Europas gegenüber anderen Weltregionen säen Zweifel an Bradfords Europa-optimistischer Diagnose. Und selbst wenn sich Europa durchsetzt, wenn der Regulierungs- und Bürgerrechtsgedanke siegt: Was kann man sich darum kaufen? In welche reale Macht lässt sich das ummünzen? Wie verleiht das Stärke?

Vielleicht sind das auch genau die falschen Fragen: Weisen solche Fragen darauf hin, dass Fragesteller bereits den Wert von Freiheit und Privatsphäre für alle über Bord geworfen haben und sich stattdessen mit der Vorstellung von Macht für wenige anfreunden.